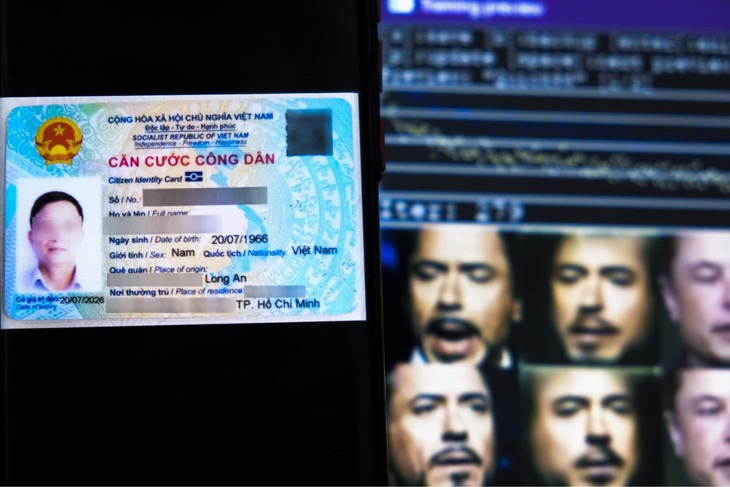

Việc sử dụng các công cụ deepfake dễ dàng, trong khi chưa có giải pháp nào để chặn lọc - Ảnh: HOÀNG NAM

Cách sử dụng deepfake của các nhóm lừa đảo ngày càng tinh vi hơn, theo cảnh báo của Cục An toàn thông tin, Bộ Thông tin và Truyền thông tại họp báo thường kỳ ngày 6-11.

"Trước đây, có thể nhận biết các video deepfake qua ngữ điệu, cử động môi và sự trùng khớp giữa nhân vật, bối cảnh, âm thanh. Đến bây giờ đã có những công cụ giúp tạo video giống thật đến 70-80%, dễ nhầm lẫn khi nhìn bằng mắt thường", theo ông Nguyễn Phú Lương - phó giám đốc Trung tâm Giám sát an toàn không gian mạng quốc gia (NCSC), Cục An toàn thông tin.

Nhiều công cụ deepfake bao gồm cắt ghép khuôn mặt, dựng video từ ảnh, khớp nối âm thanh với chuyển động môi, là các phần mềm nguồn mở. Bất kỳ ai cũng có thể tiếp cận được các phần mềm này, và các video hướng dẫn sử dụng cũng sẵn có trên YouTube, Facebook.

Việc tạo ra video deepfake dễ dàng, trong khi đó gần như chưa có giải pháp nào để chặn lọc.

"Bối cảnh chung trên thế giới là gặp khó khăn trong việc chặn lọc những video deepfake khỏi không gian mạng. Giải pháp hiện tại là cố gắng tuyên truyền, khuyến cáo người dân thận trọng với mọi thông tin tiếp cận được, luôn tuân thủ các nguyên tắc về an toàn thông tin", ông Lương cho biết.

Đầu tiên, người dùng mạng cần tìm cách kiểm chứng mọi thông tin nhận được bằng cách kiểm tra chéo giữa các nguồn khác nhau. Trong trường hợp nhận được video từ người thân với tình huống hoặc yêu cầu bất ngờ, hãy cố gắng kéo dài cuộc gọi video call để biết chắc đang nói chuyện với người thật chứ không phải đoạn video dựng sẵn.

Sau đó, người dùng cần xác minh lại qua các kênh khác, ưu tiên các kênh trực tiếp hoặc gọi điện thoại qua mạng viễn thông.

Trong hầu hết các trường hợp, hình thức lừa đảo trực tuyến này nhằm lừa đảo tài chính. Do đó, khi người dân nhận được các cuộc gọi video liên quan đến yêu cầu chuyển tiền, vay mượn thì cần xác nhận kỹ và trong mọi trường hợp không chuyển tiền cho các số tài khoản lạ, kể cả tài khoản có tên giống với tên người thân, bạn bè.

"Có một số công cụ kiểm chứng video có phải deepfake hay không, ví dụ như Intel Fake Catcher hay Microsoft Video Authenticator", ông Lương cho biết.

Ngoài ra, khi nhìn bằng mắt thường có thể thấy khuôn mặt nhân vật trong video deepfake ít biểu cảm, ánh sáng kỳ lạ và bóng đổ không đúng vị trí, nhân vật không có các hành động đưa tay lên gãi mặt hoặc dụi mắt, vì các hành động này sẽ gây lỗi cho AI.

Tối đa: 1500 ký tự

Hiện chưa có bình luận nào, hãy là người đầu tiên bình luận