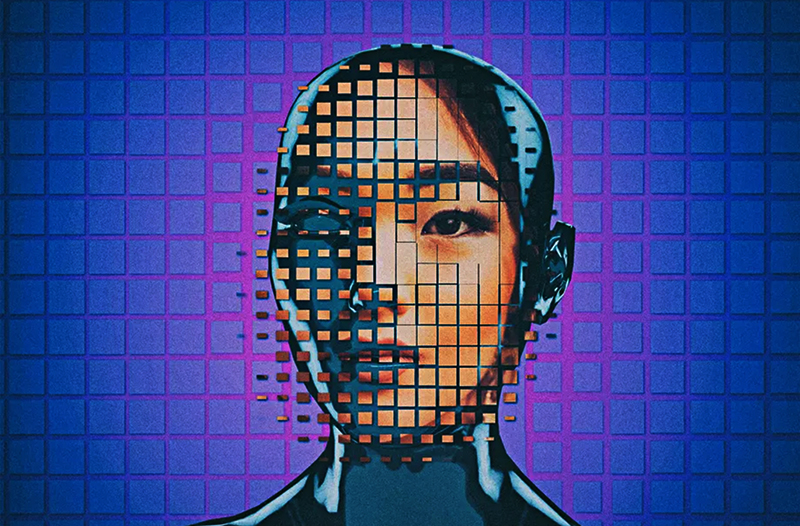

DeepFake: Siêu Làm Giả!

Thuật ngữ DeepFake được tạo nên với sự kết hợp giữa “Deep Learning” (học sâu) và “Fake”(giả tạo).

Vào cuối năm 2017, có một người dùng trên mạng xã hội Reddit tự xưng là “Deepfakes” đã chia sẻ nhiều video hoán đổi khuôn mặt trên cơ thể của một số diễn viên nữ, trong cả những video khiêu dâm và không khiêu dâm, đạt độ chính xác khá cao.

Thoạt đầu, DeepFake là một kỹ thuật tổng hợp hình ảnh của con người dựa trên trí tuệ nhân tạo, với kỹ thuật Máy học (Machine Learning), sử dụng các mạng nơron, đặc biệt là Mạng chống đối tạo sinh (Generative Adversarial Network, viết tắt là GAN) - công nghệ sản sinh dữ liệu giống với dữ liệu gốc, tức dữ liệu thật, nhiều nhất.

Bước qua đầu năm 2018, Diễn đàn Deepfakes đã thu hút hơn 50.000 thành viên, thực hiện các yêu cầu cho video, chia sẻ phim tự chế và trao đổi... hồ sơ của những người nổi tiếng, tham gia rèn luyện thêm cho các chương trình trí tuệ nhân tạo của họ.

Khi kết quả các sản phẩm làm giả ngày càng trở nên “đáng tin” hơn, sẽ tới lúc một người dùng phần mềm cỡ nghiệp dư cũng có thể khiến bạn bè, bạn học, đồng nghiệp và người quen của mình xuất hiện trong phim khiêu dâm, đổi vai với các ngôi sao Hollywood.

Mới đây, hôm 3-9-2019, hãng tin Reuters cho biết: ứng dụng ZAO của Trung Quốc, chạy trên điện thoại thông minh, đã dùng công nghệ DeepFake hỗ trợ người dùng ghép mặt mình để... trở thành nhân vật chính trong những phim, hay trong bất cứ video nào có người nổi tiếng thủ vai. Kết quả “tráo mặt” ấy được nhận xét là đạt độ chân thật đáng kinh ngạc.

Tuy vậy, ZAO đang bị phản đối vì buộc người dùng phải cung cấp “miễn phí và vĩnh viễn” loạt hình chụp khuôn mặt của họ, gây ra mối lo ngại về việc hình ảnh của người dùng có thể bị sử dụng cho những mục đích khác.

Thêm nữa, các ứng dụng deepfakes còn lan qua cả mục đích chính trị, bắt đầu từ những châm biếm chính trị song sẽ dẫn tới những tin tức giả mạo hay gì nữa thì khó mà biết.

Theo các nhà nghiên cứu, “điểm mới lạ” của các ứng dụng Siêu Làm Giả là các tác phẩm giả có thể sớm được thực hiện từ bất kỳ ai.

“Mọi người cần biết rằng, chỉ trong vài tháng, việc tạo ra những hình ảnh và video giả mạo sẽ không còn dễ nhận ra là giả mạo” - chuyên gia về trí tuệ nhân tạo Alex Champandard lưu ý.

Thêm mánh mới: Nhái giọng

Mới hồi tháng 3 năm nay, một băng tội phạm đã dùng một chương trình tạo giọng nói bằng ứng dụng trí tuệ nhân tạo để nhái y chang giọng của viên giám đốc điều hành một tập đoàn ở Đức, ra lệnh qua điện thoại cho giám đốc một công ty năng lượng trực thuộc ở Anh.

Qua điện thoại, “giọng sếp” yêu cầu bên Anh chuyển khoản số tiền 243.000 USD, trong vòng một tiếng đồng hồ, cho một nhà cung ứng ở Hungary, sau đó sẽ được công ty mẹ hoàn trả tức thì.

Nghe giọng nói quen thuộc, mang đặc trưng tiếng Đức của cấp trên, người giám đốc bên Anh đã làm theo yêu cầu chuyển khoản mà không chút nghi ngờ.

Chưa hết, vì “giọng sếp” lại yêu cầu tiếp một giao dịch khẩn nữa. Tới đó thì ông giám đốc bên Anh từ chối thực hiện, vì kiểm tra lại mà chẳng thấy công ty mẹ chuyển trả xu nào. Hóa ra số tiền mà ông đã nghe “lời sếp” chuyển tới Hungary lại bị gởi tận... Mexico và một số nơi khác, rồi dĩ nhiên chẳng thể nào... đòi lại.

Bốn tháng sau, tới tháng 7 năm nay, Tổng cục Điện tử quốc gia Israel (INCD) đã chính thức cảnh báo về “một loại tấn công mạng mới”, sử dụng trí tuệ nhân tạo để giả giọng lãnh đạo cấp cao, ra lệnh cho nhân viên làm nhiều việc gây hại cho nội bộ doanh nghiệp, như chuyển tiền, hay gởi tài liệu mật...

Trả lời phỏng vấn của báo The Wall Street Journal, ngày 30-8-2019, chuyên gia Jake Moore của Công ty bảo mật ESET (Slovakia) nói: “Chúng ta đã thấy công nghệ DeepFake bắt chước những người nổi tiếng ở định dạng video, nhưng phải mất khoảng 17 giờ để tạo ra được một sản phẩm video đủ thuyết phục. Trong khi đó, sử dụng trí tuệ nhân tạo để giả giọng nói thì chỉ cần ít bản ghi hơn để sản xuất. Khi sức mạnh điện toán tăng lên, chúng ta sẽ bắt đầu thấy những thứ này càng trở nên dễ làm hơn”.

Một mối nguy mới: DeepNude “Lột Sạch”

Hồi tháng 6 năm nay, trên Internet đã xuất hiện DeepNude - một ứng dụng Windows có thể tải về từ mạng, cho phép người dùng... lột quần áo khỏi những bức hình của các cô các bà, với lời giải thích rằng “mỗi bức hình tinh chỉnh bởi phần mềm này đều được xem như một trò đùa giả mạo”.

Muốn có hình chất lượng (độ phân giải cao), người dùng phải mua DeepNude bản premium với giá 99 USD.

DeepNude chủ yếu nhắm tới phái nữ, không tạo được hình đàn ông khỏa thân giả mạo. Chỉ trong vài giây, sau khi được cung cấp bức hình một người đàn bà bất kỳ đang mặc quần áo bình thường, DeepNude có thể biến hình đó thành một hình khỏa thân, với người trong ảnh sẽ bị “lột sạch”.

Sau khi dùng thử DeepNude, các biên tập viên của trang công nghệ The Verge cho biết: chương trình dễ tạo ra hình khỏa thân giả mạo nếu người trong hình gốc đang mặc bikini, hoặc quần áo hở hang. Với hình người bận quần áo kín đáo, phần “da thịt” được trí tuệ nhân tạo đắp vô sẽ trông hơi mờ, và có “hạt” (pixelate).

Những bức hình khỏa thân do DeepNude tạo ra nhờ thuật toán trí tuệ nhân tạo đều có đóng dấu (watermark), như một hình thức xác nhận đó là sản phẩm giả mạo (hình fake).

Dĩ nhiên, với những bức hình chất lượng thấp (tù mù), và đã được người sử dụng chủ động xóa đi dấu watermark thì cảnh “khỏa thân” trong đó sẽ nom “y như thật”, do đó sẽ rất tai hại với người trong hình bị chơi khăm: họ dễ bị quấy rối, làm nhục, đe dọa, thậm chí bị “trả thù tình”, hay bị tống tiền...

Đó là chưa kể DeepNude cũng có thể được dùng để tạo hình khỏa thân của trẻ vị thành niên. Theo nhiều luật sư, hành vi tạo ra và sử dụng hình khỏa thân do trí tuệ nhân tạo mà có có thể cấu thành tội phỉ báng.

Bởi vậy, DeepNude chỉ tồn tại chưa hết cái tháng 6 năm 2019, với đủ hai thái cực trái ngược nhau: vừa được chép về và chia sẻ ào ào bản miễn phí, lại vừa gây ra một làn sóng phản ứng quyết liệt từ cộng đồng mạng, bởi những nguy hại tiềm tàng cho những ai lỡ bị biến thành “mục tiêu” của kẻ xấu.

Hồi 11 giờ 11 phút ngày 27-6-2019, “Alberto” - biệt danh của người tạo ra DeepNude - đã đăng trên Twitter thông báo “sự kết thúc của DeepNude”, vì đã “không bao giờ nghĩ rằng nó sẽ lan truyền mạnh mẽ”, “không thể kiểm soát lưu lượng”, và “khả năng mọi người sẽ lạm dụng nó là quá cao”.

“Alberto” cũng cảnh báo: “Chắc chắn một số bản sao của DeepNude sẽ được chia sẻ trên web, nhưng chúng tôi không muốn là người bán nó. Tải xuống phần mềm từ các nguồn khác hoặc chia sẻ nó bằng bất kỳ phương tiện nào khác sẽ trái với các điều khoản của trang web của chúng tôi. Từ giờ trở đi, DeepNude sẽ không phát hành các phiên bản khác và không cấp cho ai sử dụng. Thậm chí không có giấy phép để kích hoạt phiên bản Premium. Những người chưa nâng cấp sẽ được hoàn lại tiền”.

Bắt đầu cuộc chiến chống DeepFake…

Với lưu ý rằng “DeepNude còn lâu mới là chương trình duy nhất cho phép người ta tạo ra những cảnh khỏa thân giả mạo”, báo The Guardian (29-6-2019) đã cảnh báo: Động lực phía sau rất nhiều ứng dụng công nghệ Siêu Làm Giả này là để kiểm soát và làm nhục phụ nữ. Sự phát triển của công nghệ DeepFake sẽ khiến Internet càng trở nên khó khăn hơn theo cấp số nhân đối với phụ nữ. Thậm chí, Internet có thể là một nơi cực kỳ độc hại cho phụ nữ, và “chúng ta sẽ đối mặt với một tương lai - nơi phụ nữ có thể không thể tồn tại trực tuyến”!

Mới đây, hôm 6-9-2019, hãng tin Reuters cho biết: mạng xã hội Facebook đã đầu tư 10 triệu USD cho cuộc thi “Deepfake Detection Challenge”, nhằm thúc đẩy việc nghiên cứu để phát hiện và xử lý những video giả mạo, từ đó tạo ra một công cụ phát hiện các sản phẩm deepfakes.

Dự án này của Facebook có sự hợp tác từ Microsoft và Liên minh các đối tác về trí tuệ nhân tạo, cùng các nhà nghiên cứu từ một số trường đại học.

Tuy vậy, cuộc thi “Deepfake Detection Challenge” chỉ tập trung đối phó với các video giả mạo, trong khi ngày sẽ càng có thêm nhiều ứng dụng DeepFake cho những đối tượng phương tiện khác, như làm giả giọng nói...

Ngay từ đầu năm ngoái, tờ báo Đức Aargauer Zeitung ra ngày 3-2-2018 đã báo động: mọi người nên biết rằng mọi thứ có thể bị hủy hoại nhanh chóng ra sao với công nghệ Siêu Làm Giả. Báo dẫn lời nhà nghiên cứu về trí tuệ nhân tạo Alex Champandard, rằng cạm bẫy chủ yếu chính là nhân loại có thể rơi vào một thời đại không còn có thể xác định được liệu nội dung của bất kỳ loại phương tiện nào (hình ảnh, video, giọng nói, văn bản...) có tương ứng với sự thật hay không.

Biếm Họa

Biếm Họa

Video

Video

Trạm hoạt hình

Trạm hoạt hình

Showbiz Muôn Màu

Showbiz Muôn Màu

Truyện Tranh

Truyện Tranh

Đời Cười

Đời Cười

Sức Khỏe

Sức Khỏe

Thể Thao Cười

Thể Thao Cười

Tối đa: 1500 ký tự

Hiện chưa có bình luận nào, hãy là người đầu tiên bình luận